¿AI más barato, más inteligente? Los investigadores de UW, AI2 y Stanford impulsan el modelo al hacerlo "pensar" más largo

En una nueva demostración del potencial para mejorar la inteligencia artificial sin romper el banco, los investigadores de la Universidad de Washington, el Instituto Allen para AI (AI2) de Seattle y la Universidad de Stanford han desarrollado una técnica que hace que los modelos de IA "piensen" más tiempo antes de responder.

La idea es aumentar las habilidades de razonamiento de la IA y al tiempo que reduce significativamente los costos de capacitación.

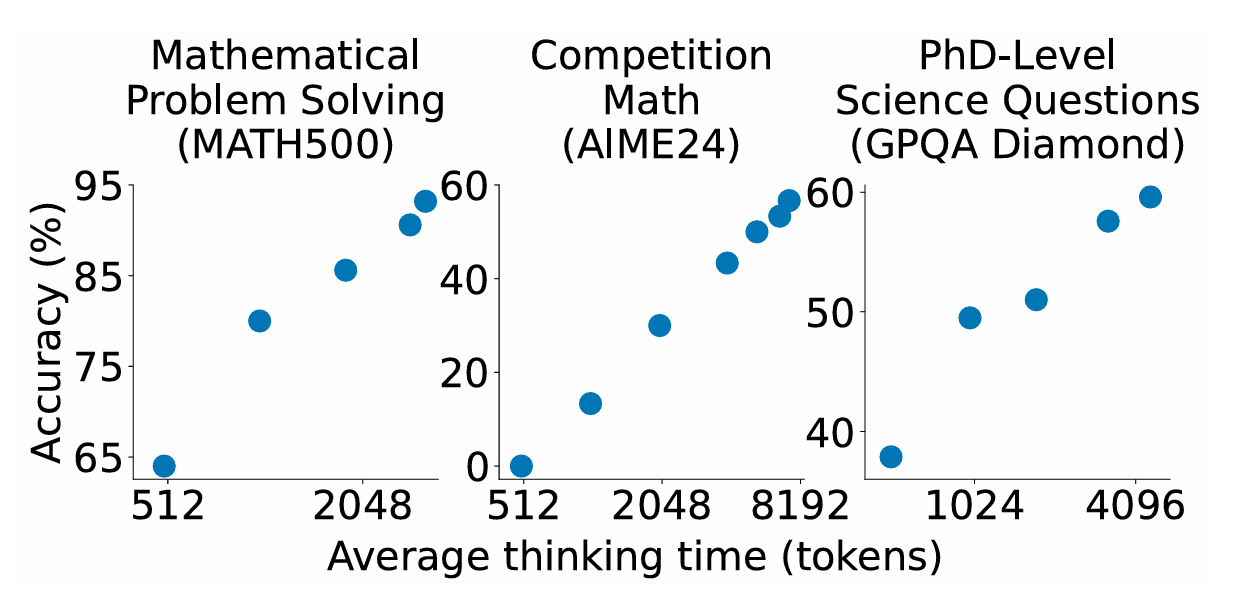

El método de "escala de tiempo de prueba" simple, descrito en un artículo de investigación reciente, utiliza una técnica simple que obliga a la IA a continuar procesando si comienza a responder a una consulta demasiado temprano. Los investigadores encontraron que esta técnica ayuda al modelo a revisar y mejorar su respuesta, a menudo evitando errores en la producción.

El modelo, los datos y el código para el modelo, denominado S1, son de código abierto en GitHub.

Es parte de una tendencia más amplia, ejemplificada por Deepseek, para encontrar nuevas formas eficientes de mejorar el rendimiento de la IA al tiempo que reduce los costos de la capacitación del modelo de IA. Los recursos informáticos descritos en el documento para capacitar al modelo de razonamiento S1 ascenderían a menos de $ 50 en créditos de computación en la nube, informa TechCrunch.

Los investigadores enumerados en el documento son: Niklas Manennighoff (Stanford, AI2, contextual AI), Zitong Yang (Stanford), Weijia Shi (UW), Xiang Lisa Li (Stanford), Fei-Fei Li (Stanford), Hannananh-Hajishirzi (UW,, AI2), Luke Zettlemoyer (UW), Percy Liang (Stanford), Emmanuel Candès (Stanford) y Tatsunori Hashimoto (Stanford).

Anteriormente: Allen Institute for AI Challenes Deepseek en puntos de referencia clave con un gran nuevo modelo de IA de código abierto